Wenn Computer an Katzen scheitern

Schach ist leichter als eine Katze zu erkennen. Neuronale Netze und die Forschung an Künstlicher Intelligenz haben uns viel über menschliche Intelligenz gelehrt.

Auf den Punkt gebracht

- Was ist Intelligenz? Unser Verständnis von Intelligenz hat sich unter anderem durch die Forschung an Künstlicher Intelligenz geändert.

- Wie lernen Maschinen? Mittels Neuronaler Netze beherrschen Maschinen mittlerweile auch komplexe Vorgänge – zum Beispiel die Gesichtserkennung.

- Wie funktionieren Neuronale Netze? Das ist sowohl spannend wie unheimlich: Wir wissen nicht, was im Inneren diese Netzwerke vorgeht oder wie sie lernen.

- Sollten wir uns fürchten? Ja und Nein. Maschinen werden sich vorerst nicht verselbständigen. Aber es ist realistisch, dass sie Menschen mehr und mehr ersetzen.

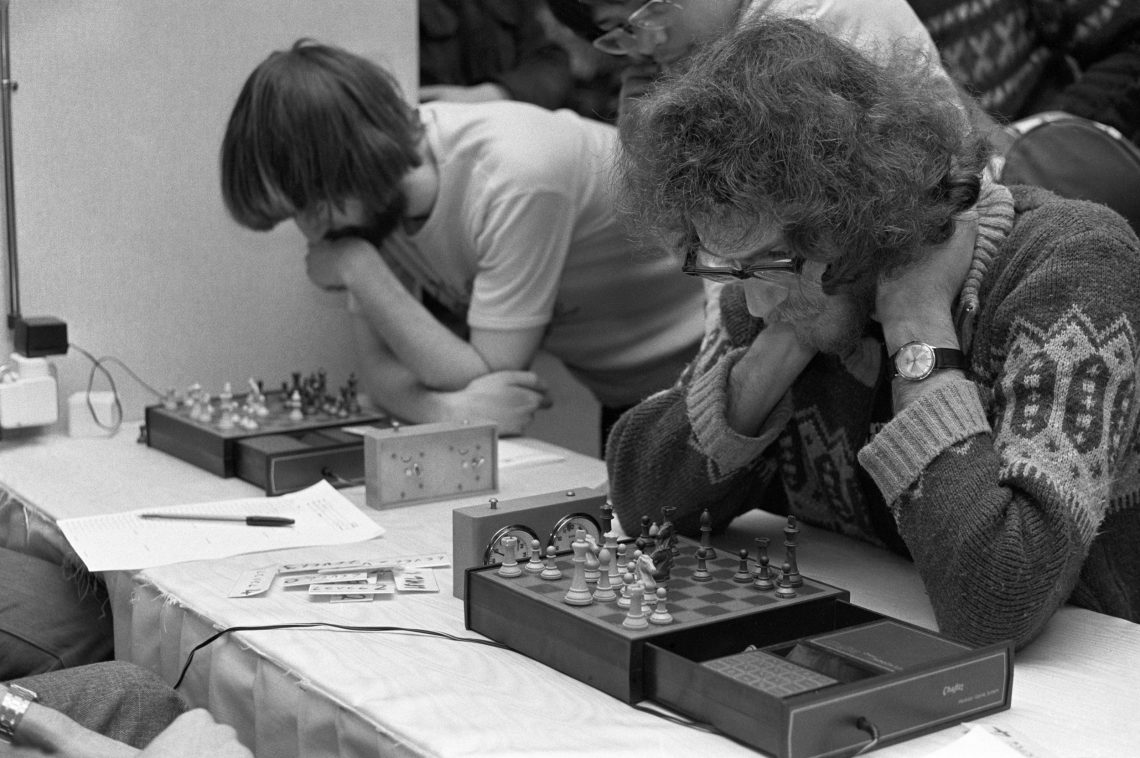

Was ist beeindruckender: Den amtierenden Schachweltmeister zu schlagen oder die eigene Großmutter zu erkennen? Die Antwort scheint auf der Hand zu liegen, aber sie ist komplexer als es zunächst scheint. Für eine Künstliche Intelligenz (KI) war es lange Zeit einfacher, in Schach zu gewinnen als ein Gesicht zu erkennen.

Ein Schachcomputer ist ein relativ einfacher Mechanismus, der in sehr kurzer Zeit hunderttausende Züge ausprobieren und analysieren kann; weshalb er dem Menschen sehr schnell überlegen ist. Die Leistung der Gesichtserkennung ist umgekehrt eine sehr komplexe, die einen klassischen Schachcomputer komplett überfordern wurde. Dazu brauchte es erst die Entwicklung des sogenannten Tiefen Lernens mit künstlichen Neuronalen Netzen, die einem Computer nun auch das ermöglichen.

Mehr im Dossier Künstliche Intelligenz

- Hauke Behrendt zur Frage: Automatisieren wir unsere Jobs weg?

- Anne Foerst erklärt, warum die Roboter dumm bleiben

- Oliver Bendel beantwortet die Frage: Brauchen Computer eine Moral?

- Sepp Hochreiter über ein Missverständnis: Computer, löse unsere Probleme!

Sehen ist nicht trivial

Dieses simple Beispiel zeigt bereits: Intelligenz zu definieren ist nicht einfach, und es gibt tatsächlich keine allgemein gültige und anerkannte Definition von Intelligenz. In der Forschung zur Künstlichen Intelligenz (KI) wurde Intelligenz zunächst als die kognitive Fähigkeit des Menschen betrachtet, Probleme zu lösen. Die Erkenntnis, dass das nicht ausgereicht hat, um menschlicher Intelligenz wirklich nahe zu kommen, hat letztendlich auch unser Verständnis von menschlicher Intelligenz gewandelt: Natürlich würde niemand die Fähigkeit, seine Großmutter zu erkennen, als Intelligenz bezeichnen, aber die Leistung, die dahintersteht, ist viel stärker in den Fokus gerückt.

Es gibt eine Anekdote aus den Siebzigern, dass ein Professor einem Informatik-Studenten als Sommerprojekt die Aufgabe gegeben hat, ein visuelles Bilderkennungsprogramm zu schreiben, um Objekte und Personen zu erkennen – er dachte fälschlicherweise, das sei trivial. Wir haben mittlerweile erkannt, wie komplex manche Vorgänge in unserem Gehirn sind, die wir zuvor vielleicht als selbstverständlich erachtet hätten.

Auch Maschinen machen Fehler

Was die menschliche Intelligenz also ausmacht, ist alles zusammen und noch mehr – die umfassende Wahrnehmung, das Verstehen der Umgebung und das Zusammenführen mehrerer Quellen sowie die Möglichkeit, mit Emotion und Empathie auf einen anderen Menschen einzugehen und einen fortführenden Dialog zu führen.

An der Medizinischen Universität Wien beschäftigen wir uns sehr stark mit KI im medizinischen Bereich, und da kommt natürlich oft die Frage, ob die Maschine den Menschen bald ersetzen wird. Und da ist die Antwort immer: Nein, weil ein Arzt oder eine Ärztin genau diese Fähigkeiten menschlicher Intelligenz braucht, um einen Patienten medizinisch zu versorgen. Es reicht nicht der Befund – also etwa die Erkennung eines Tumors auf einem Röntgenbild –, sondern es braucht auch die Fähigkeit, dem Patienten zu erklären, was das jetzt für ihn heißt. Das kann eine KI nicht – und sie wird es noch sehr lange nicht können.

Das heißt nicht, dass es nicht große Fortschritte in der Forschung gibt: Bei der Bilderkennung, bei der sich Computer bislang eben sehr schwergetan haben, gibt es nun beeindruckende Erfolge. Eine KI kann einen Hautausschlag mittlerweile besser klassifizieren und diagnostizieren als jeder Dermatologe. Interessanterweise haben wir dennoch Probleme, dieser Diagnose zu trauen: Selbst wenn wir wissen, dass eine KI besser darin ist, ein bösartiges Melanom zu erkennen, haben wir trotzdem mehr Angst davor, dass sie einen Fehler machen könnte als dass ein menschlicher Arzt einen Fehler macht.

Ein paralleles Phänomen gibt es bei selbstfahrenden Autos: Wir diskutieren stundenlang, wie gefährlich es wäre, wenn ein Fußgänger nicht rechtzeitig erkannt wird und es zu einem Unfall kommt, aber wir haben nicht dieselben Diskussionen über die vielen Todesfälle, die wir jetzt schon im Straßenverkehr haben aufgrund falscher Reaktionen von Menschen – das sehen wir als gegeben an. Es wird immer eine gewisse Fehlerquelle geben, das müssen wir auch der KI zugestehen.

Künstliche Intelligenz war nicht immer intelligent

Fehlerquellen sind oft menschengemacht: Eine KI ist immer nur so gut, wie die Daten, mit denen wir sie füttern – wenn sie fehlerhafte oder unzureichende Daten bekommt, wird sie falsches lernen. Sie sind auch oft leicht manipulierbar. Ein Experiment an einem System, das Katzen- und Hundebilder unterscheiden kann, hat gezeigt, dass es bisweilen reicht, ein paar Pixel zu verändern, um dem System weiszumachen, dass ein Katzenbild einen Hund zeigt – obwohl es für das menschliche Auge einwandfrei als Katze identifizierbar ist.

KI hat einmal jemand spöttisch so definiert: Es ist alles, was Maschinen noch nicht können.

Kommunikation ist ein weiteres Gebiet, bei dem die Maschinen dem Menschen noch weit unterlegen sind: Siri und Alexa, die Sprachassistenten von Apple und Google, können keinen ordentlichen Dialog aufrechterhalten. Sie verstehen eine Abfrage, aber wenn man versucht, eine Unterhaltung zu führen, sieht man sofort, dass da keine echte Intelligenz dahintersteckt. Auch von jeglicher Kreativität sind Maschinen noch weit entfernt.

Auch das kann sich natürlich ändern. KI hat einmal jemand spöttisch so definiert: Es ist alles, was Maschinen noch nicht können. Wenn sie es dann können, gilt es als Mainstream-Informatik. Die größten Fortschritte bei der KI-Forschung in den vergangenen Jahren – eben etwa bei der Gesichts- und Bilderkennung – sind mit Hilfe der bereits erwähnten neuronalen Netze entstanden. Diese neuronalen Netze wurden in den Achtzigern noch gar nicht als Teil der KI betrachtet; sondern eher als die Spinnereien von ein paar Kognitionswissenschaftlern. Jetzt ist es umgekehrt: KI wird fast gleichgesetzt mit neuronalen Netzwerken, die regelhafte Problemlösung – siehe Schachcomputer – ist sehr stark in den Hintergrund gerückt. Jener Computer, der meisterhaft Go spielt, das komplexeste von Menschen entwickelte Brettspiel, basiert beispielsweise schon auf neuronalen Netzwerken.

Wie Neuronale Netze funktionieren

Das ist auch für unser Verständnis menschlicher Intelligenz von Relevanz, denn das Lernen neuronaler Netze ist inspiriert von der Funktionsweise des Gehirns. Die Idee ist bereits in den 1940ern entstanden, der wesentliche Aspekt ist, dass Verbindungen von Neuronen langfristig langsam adaptiert und geändert werden – das System lernt. So genannte „convolutional neural networks“ ähneln im Aufbau – zumindest grob – dem visuellen System eines hoch entwickelten Gehirns wie dem des Menschen. Zunächst werden Bildpunkte in kleine Eigenschaften zusammengefasst – etwa hell/dunkel –, im nächsten Schritt zu komplexeren Merkmalen, und so geht das weiter und weiter, bis sich im visuellen Kortex die Wahrnehmung eines Objekts formt.

Zahlen & Fakten

Hund? Katze?

Convolutional Neural Networks werden hauptsächlich zur Bild-, Sprach und Textverarbeitung eingesetzt und sind darin mittlerweile besser als jeder Mensch. Wie bringt man einem neuronalen Netzwerk aber bei, Hunde und Katzen zu unterscheiden? Das ist nicht so simpel: Es gibt verschiedenste Arten von Hunden und Katzen, die sich oft nicht sehr ähnlich sind. Und sie alle haben gemeinsame Merkmale, etwa vier Beine, eine Schnauze und einen Schwanz.

Die Bilder werden dazu in mehreren Schichten analysiert, die erste ist die Convolutional-Schicht: Hier werden zunächst bestimmte simple Merkmale, etwa Kanten oder Formen erkannt, mit jeder weiteren Ebene werden die Merkmale komplexer. In der darauf folgenden Pooling-Schicht werden alle überflüssigen Daten verworfen, was die Datenmenge verringert. Am Ende steht eine vollständig verknüpfte Schicht – das Objekt wird entweder als Katze oder Hund klassifiziert. Am Ende steht beim lernenden System die Feedback-Schleife: Es wird ihm mitgeteilt, dass der von ihm identifizierte Hund eigentlich eine übergewichtige Katze ist – das Netzwerk muss dann seine Analyse des Bildes dementsprechend anpassen.

Die „Convolutional Neural Networks“ hatten einen doppelten Nutzen: Nicht nur, dass wir die Bilderkennung nun massiv verbessert haben, wir haben auch ein besseres Verständnis davon, wie das Gehirn funktioniert. Davon, es als Ganzes zu verstehen, sind wir aber immer noch weit entfernt. Wie wir etwas nicht nur erkennen, sondern aus diesem Erkennen eine Schlussfolgerung ziehen, eine Handlung setzen, darüber reden – da fehlen uns noch sehr viele Puzzleteile. Wiederum sowohl im Verständnis des Gehirns als auch in der Möglichkeit, das für KI nachzubauen und zu implementieren.

Wir wissen nicht, wie Maschinen lernen

Computer sind aber dank neuronaler Netzwerke wie das Gehirn mittlerweile in der Lage, selbständig Dinge zu lernen, die wir ihnen nicht einprogrammiert haben. Das löst bei manchen Menschen Ängste aus, die bis zu einem gewissen Grad auch verständlich sind: Denn es stimmt, dass wir nicht voraussehen können, was und wie ein System gelernt hat – was sich im Inneren des Systems abspielt, bleibt oft eine Blackbox. Wir können das System validieren, indem wir es testen, aber wir können nicht erklären, warum es das kann und wie es das gelernt hat.

Diese Utopien, dass Roboter plötzlich uns Menschen ausbooten, das ist nach wie vor Science-Fiction.

Die gesamte Forschungsrichtung der „explainable AI“ versucht herauszufinden, wie diese Systeme lernen, um da wieder ein bisschen Licht hineinzubringen. Es erzeugt berechtigterweise Unbehagen, dass man das System nicht immer unter Kontrolle hat. Aber trotzdem: Diese Systeme können sich nicht selbständig machen. Diese Utopien, dass Roboter plötzlich uns Menschen ausbooten, das ist nach wie vor Science-Fiction.

Rationale und irrationale Ängste

Es ist also wichtig, bei KI irrationale und rationale Ängste zu unterscheiden. Als irrational würde ich die Angst einstufen, dass Maschinen ein Eigeninteresse oder gar so etwas wie Bewusstsein entwickeln könnten: Keines dieser Systeme hat in irgendeiner philosophisch oder psychologisch rechtfertigbaren Argumentation eine Intention hinter dem, was es tut. Sie sind relativ mechanistische Ausführer. Es kommt natürlich vor, dass diese Systeme etwas tun, das wir nicht verstehen; und manchmal kann das auch gefährlich sein. Aber ein Roboter kann keinen eigenen Willen entwickeln.

Online bis zur Erschöpfung

Es gab vor ein paar Jahren die Geschichte, dass sich ein Security-Roboter in einer Shoppingmall in Washington DC in einem Pool ertränkt hätte – ein klassisches Beispiel dafür, dass wir in ein simples Fehlverhalten menschliche Verhaltensmuster hineinlesen. Er hatte natürlich nicht die Intention, sich umzubringen. Diese Tendenz des Menschen, menschliche Eigenschaften zu sehen, wo sie gar nicht sind, wird in der KI-Forschung auch aktiv genutzt: Man kann nach außen sehr leicht den Anschein erzeugen, dass ein Roboter Gefühle hätte, weil er traurig schaut. Aber auch das ist mechanistisch: Ich baue den Zustand der Traurigkeit ein, der verknüpft ist mit einem bestimmten Gesichtsausdruck.

Was Neuronale Netze mit Bewusstsein zu tun haben

Ist es komplett ausgeschlossen, dass sich in einer Blackbox eines neuronalen Netzes irgendwann so etwas wie Bewusstsein bildet, ohne dass wir das überhaupt bemerken? Nein, aber in unserer Lebenszeit ist es doch sehr unwahrscheinlich. Das „Human Brain Project“, das versucht, das menschliche Gehirn zu simulieren, hatte anfangs auch die – vielleicht etwas naive – Hoffnung, dass sich ein neuronales Netz wie das Gehirn verhalten wird, wenn es nur groß genug ist – und damit irgendwann auch Bewusstsein zeigt. Aber es zeigt sich mittlerweile, dass wir selbst bei unserem Gehirn weit davon entfernt sind, zu verstehen, wie Bewusstsein zustande kommt – und noch viel weiter davon, es bei Maschinen zu erschaffen.

Biohacking: Stark, schön, unsterblich?

Sorgen machen sollten uns vielmehr Entwicklungen, die zeitlich viel näher sind: Es ist eine sehr rationale Angst, dass Maschinen den Menschen in manchen Bereichen ersetzen könnten. Es gibt berechtigte Besorgnis, dass selbst manche Anbieter im Gesundheitsbereich sich aus Kostengründen überlegen, das menschliches Personal einzusparen. So wie viele Firmen bieten keinen Kundenservice mehr anbieten, sondern automatisierte Callcenter haben. Dass man sagt, bei leichten Erkrankungen muss man keinen Arzt mehr zu Rate ziehen. Dieser Entwicklung sollten wir entgegentreten anstatt uns vor Robotern zu fürchten, die sich selbständig machen.

(aufgezeichnet von Thomas Trescher)

Conclusio

Die Forschung an KI hat uns viel über unser Verständnis von menschlicher Intelligenz gelehrt: Was wir als trivial erachtet haben – etwa das Erkennen von Gesichtern – stellte sich als kompliziert heraus. Nun aber haben Maschinen gelernt, sich selbst Dinge beizubringen, ohne dass wir wissen, wie sie das tun. Das löst bei vielen Menschen Unbehagen aus, aber die Angst, dass sich Roboter deshalb selbstständig machen könnten, ist trotzdem unberechtigt – sie bleiben mechanistische Ausführer.

Sind Maschinen das Ende der Menschheit?

Sie macht uns zu Sklaven der Maschinen, verdrängt uns vom Arbeitsmarkt, und irgendwann wird sie uns sowieso alle umbringen. Oder doch nicht? Ein Plädoyer für mehr Gelassenheit im Umgang mit künstlicher Intelligenz.