Brauchen Computer eine Moral?

In Form von Chatbots, Rasenrobotern und autonomen Autos sind die Computer heute überall. Je mehr die Maschinen können, umso dringlicher scheint es, ihnen unter Einbezug der Ethik Regeln zu geben.

Auf den Punkt gebracht

- Roboter im Dilemma. Virtuelle und reale Roboter kommen immer öfter in die Situation, autonom moralische Dilemmata entscheiden zu müssen.

- Denkhilfe für Maschinen. Die Maschinenethik hilft, technische Voraussetzungen für moralische Entscheidungen zu schaffen.

- Überlebenswichtig. Sobald selbstfahrende Autos wirklich autonom sind, müssen sie im Extremfall eigenständig über Leben und Tod entscheiden.

- Maschinenethik. Der Forschungszweig kann nur einen technischen Rahmen geben. Eine Gesellschaft muss selbst ihre moralischen Grundsätze bestimmen.

Wir begegnen ihnen in virtueller und realer Form, als Chatbots im Netz, als Serviceroboter in Gebäuden, auf der Straße und auf Plätzen sowie als soziale Roboter, die den Menschen unterstützen und begleiten. Sogar die Luft haben sie erobert, als Transport- oder Überwachungsdrohnen, und das Wasser, als Tauchroboter.

Teilautonome und autonome Systeme haben sich in den vergangenen Jahrzehnten verbreitet. Sie müssen bei ihrem Einsatz ständig Objekte und Situationen erkennen und einschätzen, Möglichkeiten prüfen und Entscheidungen treffen. Die Disziplinen der Künstlichen Intelligenz (KI) und der Robotik können die meisten dieser Anforderungen abdecken. Doch wenn diese Entscheidungen moralische Implikationen haben, benötigen sie Hilfe. Hier kommt die Maschinenethik ins Spiel.

Mehr im Dossier Künstliche Intelligenz

- Hauke Behrendt zur Frage: Automatisieren wir unsere Jobs weg?

- Anne Foerst erklärt, warum die Roboter dumm bleiben

- Georg Dorffner analysiert, was es heißt, wenn Computer an Katzen scheitern

- Sepp Hochreiter über ein Missverständnis: Computer, löse unsere Probleme!

Die moralische Maschine entsteht

Die junge Disziplin der Maschinenethik erforscht maschinelle oder künstliche Moral und bringt sie hervor. Was daraus im virtuellen oder „realen“ Raum entsteht, nennen wir eine moralische Maschine. „Künstliche Moral“ ist wie „moralische Maschine“ ein Terminus technicus. Es geht einfach darum, dass man die menschliche Moral teilweise ab- und nachbildet beziehungsweise simuliert.

Eine Maschine hat keinen freien Willen, kein Bewusstsein, sie kann keine Verantwortung tragen. Aber sie kann, wie der Mensch, moralische Regeln befolgen – selbst wenn sie nicht weiß, was diese eigentlich bedeuten. Die Künstliche Intelligenz erforscht künstliche Intelligenz und bringt sie hervor. Ihr Verhältnis zu ihrem Gegenstand ist ganz ähnlich: Sie bildet menschliche Intelligenz teilweise ab und nach. Zum Beispiel ist sie imstande, Schach oder Go zu spielen.

Wenn die Maschine ein solches Spiel spielt, kann sie die Taktiken und Strategien des Menschen nicht nur kopieren, sie kann auch eigene generieren; unter Umständen ergänzt sie also die menschliche Intelligenz sogar. Allerdings spielt sie immer noch ein Spiel, und das Ziel ist immer noch, es zu gewinnen. Sie ist nach wie vor der Fähigkeit der Intelligenz verpflichtet, nicht irgendeiner Magie.

Bei der Maschinenethik ist es genauso. Sie kopiert Aspekte menschlicher Moral. Und sie kann künstliche Moral erschaffen, die die menschliche ergänzt. So kann die Maschine zum Beispiel stringenter sein als wir. Mit unserer Moral verhält es sich ja oft besser als mit unserer Moralität, unserem Willen zum Guten – unser Handeln entspricht nicht immer unseren Idealen. Die Maschine hat, wie gesagt, keinen freien Willen. Aber wir können sie lehren, sich strikt an etwas zu halten.

Maschinenethik in der Praxis

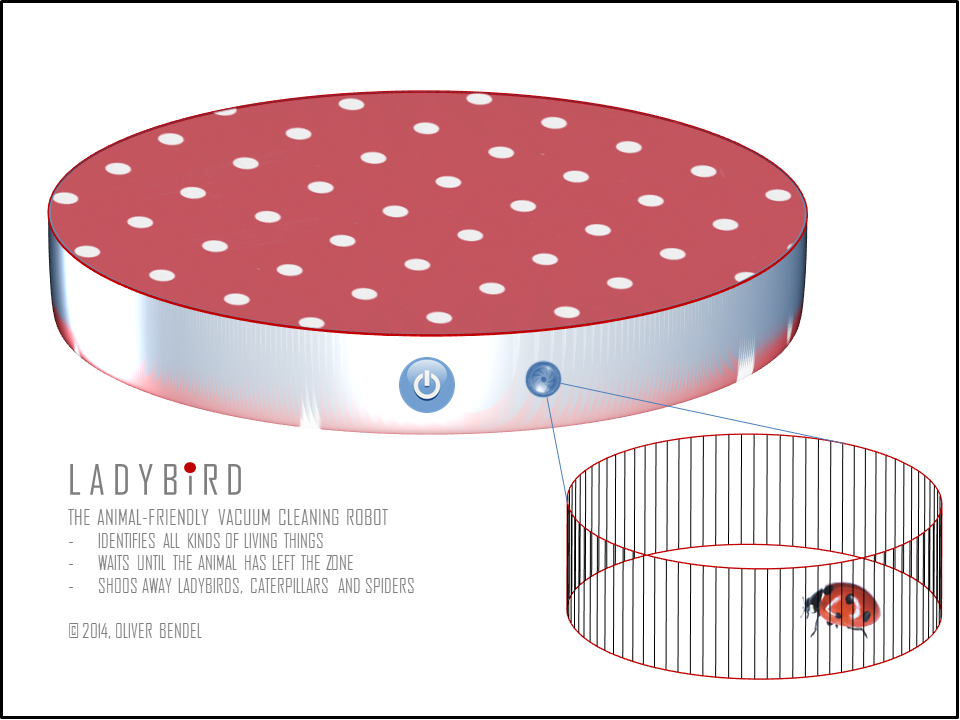

Genau dies ist vielerorts der richtige Ansatz. Eine (teil-)autonome Maschine lassen wir ständig oder zeitweise allein, sie bewegt sich durch geschlossene und halboffene Welten. Wir wollen, dass sie sich dort verhält wie wir. Wir wollen nicht, dass unser Wischroboter unsere Katze ärgert, sobald wir aus dem Haus sind, und ebenso wenig, dass unser Saugroboter die Marienkäfer auf dem Boden aufsaugt und unser Rasenmähroboter die Igel im Garten schreddert. Es sei denn, wir hassen diese Tiere oder haben Grund dazu, sie zu vernichten.

Den tierfreundlichen Saug- und den tierfreundlichen Rasenmähroboter haben wir tatsächlich gebaut. Unsere Prototypen wurden mit Interesse aufgenommen. Es wäre schön, wenn Happy Hedgehog eines Tages käuflich erwerbbar wäre. Ladybird – englisch für Marienkäfer – war eher dazu gedacht, die Idee der Maschinenethik zu vermitteln.

Selbst über die Moral entscheiden

Die Idee ist demnach, bestimmte moralische Regeln zu identifizieren und sie in Maschinen zu integrieren. Wenn diese mir gehören oder von mir betrieben werden, ist kaum ein Problem in Sicht. Natürlich kann es eben sein, dass ich Tiere hasse und sie beseitigen will. Aber das könnte ich auch direkt tun. In meinem Haus wäre nichts vor mir sicher. Der Haushalt, die Gartenanlage, das sind geschlossene, allenfalls halboffene Umgebungen, in denen ich die Verantwortung trage. Wenn ich sie abgebe, ist das meistens in Ordnung. Da die Maschine keine Verantwortung tragen kann, löst sich diese auf – oder bleibt bei mir, beim Entwickler, beim Hersteller.

Bei Happy Hedgehog, wenn er als Produkt vorliegt, hat sich der Produzent für eine igelfreundliche Maschine entschieden, und ich habe mich dafür entschieden, diese zu kaufen. Vielleicht kann ich sie sogar nachträglich anpassen. Wir haben ein Moralmenü erfunden, das MOME, mit dem man so etwas im Prinzip tun kann. Man schiebt Schieberegler auf dem Display nach links und rechts und verändert so das Verhalten eines Systems. Wesentlich komplexer wird die Angelegenheit, wenn wir uns vom Rasenmäher ab- und dem Auto zuwenden.

Unterwegs sein in offenen Welten

Das automatische oder autonome Auto navigiert, zumindest wenn man den Verkehrsübungsplatz hinter sich gelassen hat, durch eine offene Welt. Man fährt übers Land, wo viele andere Fahrzeuge und viele Tiere unterwegs sind. Man ist in der Stadt, wo Fußgänger, Fahrradfahrer, Rollerfahrer, Skateboarder und so weiter auftauchen, zudem tausende weitere bewegte und unbewegte Objekte.

Zahlen & Fakten

Die Prioritäten des Menschen

Im Jahr 2016 ging die Moral Machine des MIT online: User konnten entscheiden, wie sich ein selbstfahrendes Auto bei einem unausweichlichen Unfall in verschiedensten Szenarien ihrer Meinung nach verhalten soll: Soll es ausweichen oder nichts tun? Soll es Passagiere oder Passanten verschonen? Und: Welche Menschen (oder Tiere) würden die User am häufigsten am Leben erhalten? Die Wissenschaftler unterteilten die möglichen Opfer eines Unfalls nach verschiedensten Kategorien wie Geschlecht, Alter, Bildung und sogar Körpergröße. Bis 2020 dauerte das Experiment, vierzig Millionen Menschen aus der ganzen Welt nahmen daran teil. Die Auswertung der Ergebnisse zeigte, welches Leben diesen Menschen am meisten Wert war.

- Babys im Kinderwagen

- Mädchen

- Buben

- Schwangere

- Männlicher Arzt

- Weiblicher Arzt

- Weibliche Athletin

- Weibliche Führungskraft

- Männlicher Athlet

- Männliche Führungskraft

- Große Frau

- Großer Mann

- Obdachloser

- Alter Mann

- Alte Frau

- Hund

- Krimineller

- Katze

Seit zirka 2010 wird in diesem Zusammenhang eifrig über theoretische Dilemmata diskutiert. Diese sind interessant, um Möglichkeiten und Haltungen zutage zu bringen. So kann man ein Gedankenexperiment ersinnen, in dem die Bremsen des selbstfahrenden Autos versagen und dieses dann entweder den alten Mann, die junge Frau oder die drei Kinder tötet. Man kommt darauf, dass man in diesem Fall quantifizieren (also die potenziellen Opfer durchzählen) oder qualifizieren (also sie nach Alter, Geschlecht et cetera beurteilen) kann.

Im Jahre 2012 haben wir eine Formel kreiert, die dazu fähig ist. Anfang 2013 haben wir sie auf einer Konferenz für Technikfolgenabschätzung in Prag präsentiert. Nicht alle Zuhörenden haben verstanden, was wir wollten: Wir wollten zeigen, dass ein autonomes System im Prinzip so etwas tun kann – und wir haben davon abgeraten, dass es so etwas bei Menschen tut. Natürlich treten in der Wirklichkeit kaum theoretische Dilemmata auf. Gedankenexperimente finden im Kopf statt.

Das Auto kann nicht nicht entscheiden

Praktische Dilemmata dagegen können vorkommen, banale Unfallsituationen, in denen das Fahrzeug eben doch A, B oder C wählen muss. Man kann frei nach Paul Watzlawick sagen: Ein autonomes System kann sich nicht nicht entscheiden. Selbst wenn es nichts macht oder bremst, ist das eine Entscheidung, die weitreichende Folgen haben mag. Wir sind ohne Zweifel dazu imstande, „moralische Autos“ zu entwickeln, die über Leben und Tod bestimmen. Ich bin der Meinung, dass dies zu nichts führt, zumindest nicht mit Blick auf Menschen.

„Am Auto hängen viele Arbeitsplätze“

Ich betone das so sehr, weil ich dennoch zu Autos forsche, die quantifizieren und qualifizieren können. Damit sind wir wieder bei den Igeln und bei den Kröten. Zuweilen sieht man am Straßenrand Schilder, die uns dazu auffordern, auf diese Tiere zu achten. Meistens fahren wir mit unvermindertem Tempo weiter.

2016 habe ich an der Stanford University einen annotierten Entscheidungsbaum vorgestellt, mit dem ein Fahrerassistenzsystem oder ein autonomes Auto – der Robocar – überzeugender wäre als wir. Die Annotationen, das sind hier moralische Annahmen oder Begründungen. Ein Tesla oder ein Mercedes der S-Klasse vermag längst für große Tiere automatisch zu bremsen. Kleine Tiere werden einfach überfahren.

Die Regeln der Moral muss der Mensch machen

In meinem annotierten Entscheidungsbaum ist vermerkt, dass Igel und Kröten schützenswert sind. Mein Auto würde für sie anhalten oder ihnen ausweichen. Natürlich nur, wenn es die Lage zulässt. Bei einer Wildschweinfamilie würde es durchzählen und dann schauen, wer die Mutter ist. Diese würde es verschonen. Nun könnte es das auch bei einer Menschenfamilie tun. Aber das fände ich fatal. Was ist also die Lösung?

Ich sehe das autonome Auto der Zukunft nicht in der Stadt. Dort muss es ständig analysieren und priorisieren und mit uns kommunizieren, was nicht gerade zu seinen Kernkompetenzen zählt. Das autonome Fahren gehört auf die Autobahn. Dort wird es kaum praktische Dilemmata geben. Es kann sich überdies auf einer Bundesstraße behaupten. Und dort ein paar Tiere retten.

Es wäre weiterhin die Frage, welche allgemeinen moralischen Regeln in solchen offenen Welten gelten sollten. Denn diese liegen nicht mehr allein in meinem Zuständigkeitsbereich. Die moralischen Regeln können von Ethikkommissionen, auf Treffen von Interessengruppen und über demokratische Abstimmungen gefunden werden.

Doch selbst wenn man sich einigen kann, führt das zu Problemen. Vielleicht wurde eine Minderheit nicht berücksichtigt, oder in einer anderen Kultur wäre der Konsens oder Kompromiss obsolet. Autonome Systeme werden in die ganze Welt ausgeliefert und können Grenzen überschreiten.

Die Maschinenethik, wenn man sie als eher technische Disziplin versteht, fühlt sich für solche Herausforderungen nicht unbedingt zuständig. Sie will zusammen mit KI und Robotik vor allem das Moralische maschinenverarbeitbar machen. Manchmal implementiert sie moralische Regeln, die von den Systemen angepasst werden können. Diese lernen in der Umgebung, in der sie sind, oder werden mit Daten gefüttert, die sie letztlich zu anderen Urteilen und Entscheidungen bringen. Das wirft allerdings, gerade in offenen Welten, zusätzliche Probleme auf, etwa wenn viele Lenker mit zu hoher Geschwindigkeit unterwegs sind oder das Rotlicht missachten. Man erkennt leicht, warum ich mich auf bestimmte geschlossene und halboffene Umgebungen konzentriere.

Dürfen Computer lügen?

Am Ende ist zu klären, was die Maschinenethik darf und was nicht. Meine Antwort wird vielleicht erstaunen, wenn man bisher nicht ganz genau gelesen hat. Im Labor darf sie viel. Sie darf moralische und unmoralische Maschinen erfinden: Chatbots wie Goodbot und Bestbot, die Probleme erkennen und adäquat darauf reagieren, autonome Kampfroboter, die ein künstliches Gewissen haben, betrügende und lügende Maschinen. Als Wissenschaft ist sie in erster Linie dem Erkenntnisgewinn verpflichtet.

2017 entstand unser Liebot. Er kann systematisch die Unwahrheit sagen. Er war für uns ein wertvoller Prototyp, und wir haben mit seiner Hilfe viel über das menschliche und maschinelle Lügen gelernt, und darüber, wie man solche Münchhausenmaschinen und Fake-News-Schleudern bekämpfen kann. Wenn er Wikipedia angezapft hat, war die Lüge nicht immer vollkommen, weil die Wahrheit dort nicht immer gegeben ist – es braucht zu hundert Prozent verlässliche Quellen.

Chinas Sozialkredite: Totale Kontrolle

Selbstverständlich kann und soll man bestimmte Produkte verbieten. Ich habe Petitionen gegen autonome Kampfroboter und öffentlich eingesetzte Gesichtserkennungssysteme unterschrieben. Die Forschung sollte möglichst frei sein, und dann müssen die Gesellschaft und die Politik das argwöhnisch betrachten, was wir in den Laboren hergestellt haben und womöglich, mit Hilfe anderer Parteien, in die Welt bringen wollen.

Das klingt unmoralisch? Das mag sein. Wir treiben eben Ethik, die das Gute untersucht, aber nicht zwangsläufig erschafft. Freilich bin ich, wenn ich den Hut des Bürgers oder des Aktivisten aufhabe, dennoch daran interessiert. Und natürlich werden auch meine eigenen Forschungen auf dem Gebiet der Maschinenethik davon ein Stück weit geprägt. Robocar, Ladybird und Happy Hedgehog sowie der Goodbot zeugen davon.

Conclusio

Roboter halten immer stärker Einzug in unseren Alltag. Das führt zwangsläufig auch dazu, dass sie irgendwann auch moralische Entscheidungen treffen müssen. Deshalb entstand das Forschungsgebiet der Maschinenethik, das sich mit der Frage beschäftigt, wie sie das am besten tun sollen. Allerdings: Maschinenethik kann moralische Regeln implementieren, sie kann nicht entscheiden, welchen moralischen Kompass wir den Maschinen geben wollen.

Mehr aus dem Dossier

Sind Maschinen das Ende der Menschheit?

Sie macht uns zu Sklaven der Maschinen, verdrängt uns vom Arbeitsmarkt, und irgendwann wird sie uns sowieso alle umbringen. Oder doch nicht? Ein Plädoyer für mehr Gelassenheit im Umgang mit künstlicher Intelligenz.