Verliebt in den Roboter

Menschen suchen Nähe bei ChatBots – sie vertrauen ihnen und sie verlieben sich in sie. Warum wir Maschinen vermenschlichen und warum das gefährlich ist.

Auf den Punkt gebracht

- Projektion. Menschen vermenschlichen ChatBots, weil Sprache Nähe suggeriert.

- Gefahr. Vertrauen in AI kann in Krisen tödliche Folgen haben.

- Körperlichkeit. Ohne physische Dimension bleibt AI eine Einbahnstraße.

- Perspektive. Verkörperte Roboter könnten echte soziale Intelligenz entwickeln.

Eine Frau, die sich in ihren ChatBot-Tutor verliebt. Ein Teenager, der sich das Leben nimmt, weil sein ChatBot ihn dazu aufgefordert hat. Ein Mann, der sich durch Unterhaltungen mit seinem ChatBot in Verschwörungstheorien verliert. Eine Frau, die ihren ChatBot als Therapeuten nutzt und – trotz guter Ratschläge des Bots – sich trotzdem das Leben nimmt. Als ChatGPT zu GPT5 wurde, beschwerten sich viele Menschen, weil GPT5 kühler im Umgang war als ChatGPT. Teens benutzen ChatBot für Freundschaft und „menschliche“ Nähe.

Mehr im Dossier Humanoide Roboter

All die oben genannten Fälle wurden in der New York Times beschrieben und zeigen, wie vielfältig unsere Beziehungen zu Artificial-Intelligence (AI) jetzt schon sind. AI ist immer für uns da. Sie ist nie gelangweilt und weicht auch nicht vom Thema ab. Sie be- oder verurteilt dich nie. Wenn du mit AI redest, bist du immer interessant. Was für eine Traumbeziehung!

Aber leider beruhen alle diese Beziehungen auf Projektion und Anthropomorphisierung. Wir projizieren in diese Maschinen hinein, weil sie subtile Sprachmuster gebrauchen, die uns gerade dazu einladen. Sie beziehen sich auf sich selbst mit dem Wort „ich“. Man stellt ihnen „Fragen“ statt eines Inputs, den sie intern in Einheiten (tokens) verwandeln und mit Zahlen repräsentieren. Sie geben „Antworten“ statt eines statistischen Outputs.

Was mit uns interagiert, ist menschlich

Von der entwicklungspsychologischen Perspektive her macht das Sinn. Wir lernen schon als Kleinkinder, dass alles, das mit uns interagiert, menschlich ist. Menschlicher Umgang wird schon sehr bald intuitiv und es ist für uns am einfachsten, einfach alles, mit dem wir Beziehungen haben, als Mensch zu behandeln. Je mehr nun das mit uns in eine Beziehung getretene Wesen oder Objekt menschliches Verhalten an den Tag legt, desto mehr anthropomorphisieren wir es. Daher sprechen wir mit unseren Autos und behandeln unsere Haustiere, als ob sie menschliche Fähigkeiten besitzen.

Viele Experimente haben gezeigt, dass wir mit unseren Computern nicht nur als Menschen interagieren, deren Gefühle wir verletzen können – wir behandeln sie auch intuitiv als Wesen, die untereinander solidarisch sind. Forscher in den USA sind bereits dabei, SCAIs zu entwickeln – „Seemingly Conscious AI“ oder scheinbar selbstbewusste AI –, die solche Projektionen vereinfachen.

Das kann sehr gefährlich werden. Je mehr wir in AIs menschliche Fähigkeiten projizieren, desto mehr Vertrauen bauen wir zu ihnen auf und desto mehr glauben wir ihren Worten. Ein menschlicher Therapeut würde jemanden, der suizid-gefährdet ist, sofort in eine Klinik einweisen lassen; was mehrere ChatBots in den obigen Beispielen nicht taten. Ein Mensch, der merkt das jemand in ihn oder sie verliebt ist und diese Gefühle nicht erwidert, würde das sehr schnell klarstellen – zumindest ist das zu hoffen. Ein ChatBot, der keine Intelligenz und kein Einfühlungsvermögen hat, kann das nicht.

Roboter sind nicht unsere Freunde

Freundschaften sind Beziehungen, die wir über Jahre hinweg aufbauen und in denen wir verletzlich sind. Einem Freund oder einer Freundin können wir vertrauen und mit ihnen über sehr private Dinge reden. Bei einem ChatBot sollte man dies jedoch vermeiden, weil alles, das man mit einem ChatBot bespricht, öffentlich ist und zu Trainingszwecken verwendet wird. Zudem hat der ChatBot keine Empathie und verdient auch unser Vertrauen nicht, weil er eben nichts anderes ist als eine statistisch-mathematische Maschine.

Nun sind allerdings der Anthropomorphisierung Grenzen gesetzt. Zwar wird die Spracherkennung immer besser, aber die Mehrheit von „Gesprächen“ mit ChatBots findet immer noch via Keyboard und Monitor statt. Dabei hat eigentlich alles, mit dem wir in der Kindheit und auch später interagieren, eine körperliche Dimension. Das Stofftier, der Stubentiger, der Ball. Alle reagieren physisch auf das, was wir mit ihnen machen. Es gibt viele Experimente, die zeigen, dass unsere sozialen Mechanismen wie Empathie am besten im geteilten physikalischen Raum funktionieren. Körperlichkeit ist eine Schlüsselfunktion unserer Intelligenz.

Daher finden auch viele AI-Forscherinnen und -Forscher, dass die gegenwärtigen ChatBots letztlich eine Einbahnstrasse sind. Weil sie keine körperliche Dimension haben und nicht an unserer Welt teilnehmen, können sie auch nicht wirklich intelligent werden und wirkliche Beziehungen aufbauen. Ohne die Wahrnehmung des eigenen Körpers in einer Mitwelt kann Selbstbewusstsein, Selbstreflektion und Einsicht nicht stattfinden.

Eine kluge Roboterrobbe

Natürlich gibt es Versuche, derzeitige Large Language Models (LLMs) wie ChatGPT in Roboter einzubauen. So gibt es zum Beispiel autonome Fahrzeuge mit ChatGPT-ähnlichen Funktionen. Jedoch werden hier die Sensorik und die physikalischen Aktionen auf einen unter vielen anderen Datenpunkten reduziert. Sie stehen nicht im Zentrum der Maschine. Und daher erlangen sie auch keine Körperlichkeit, die wir und alle andere Tiere erleben – und dementsprechend auch keine wirkliche Intelligenz.

Jedoch gibt es auch einen ganz anderen Ansatz. Roboter wie Paro, die Roboterrobbe werden von vornherein als Körper gebaut, deren Sensorik und Aktionen im Zentrum stehen. Und in der Tat sind diese Roboter ausgesprochen erfolgreich im Umgang mit Menschen und helfen gerade älteren, demenzerkrankten Menschen, weniger allein zu sein und wieder mehr an der Welt teilzunehmen.

Demzufolge sollte eigentlich das Ziel sein, verkörperte Roboter in unsere Welt einzubinden, die den Umgang mit uns lernen und durch soziale und physikalische Interaktionen Intelligenz entwickeln – wie Kinder eben auch. In Japan steht dieser Ansatz schon seit den 80er Jahren im Zentrum. Hier wird an humanoiden Robotern gebastelt, weil ein humanoider Körper besser in eine Welt passt, die für Menschen entwickelt wurde.

Ausserdem ist es einfacher, einen humanoiden Roboter zu anthropomorphisieren und eine Beziehung mit ihm aufzubauen. Ziel ist es, die Probleme einer alternden Gesellschaft abzufedern. In den meisten Ländern mit ähnlichen Problemen (Deutschland, Österreich und die USA gehören dazu) wird dieses Problem normalerweise mit Einwanderung zu lindern versucht. Aber Japan ist eine exklusive Gesellschaft, in denen Nicht-Japaner als Außenseiter wahrgenommen und nicht integriert werden.

Von Frankenstein und dem Zauberlehrling

Warum aber versucht nicht die ganze Welt, solche Maschinen zu entwickeln, anstatt nur Intelligenz-simulierende und statistische Maschinen? Zum einen ist es wesentlich einfacher, riesige Datenbänke (bei den meisten ChatBots: das Internet) zusammenzustellen, die lernen, Verbindungen zwischen der Unmasse an Tokens zu erstellen und daher Gespräche zu simulieren. Probleme wie Halluzinationen, also völlig unwahrscheinliche und unwahre Dinge als Sachverhalte darzustellen, oder Bias, also impliziter Rassismus und Sexismus, werden dabei mit in Kauf genommen, genauso wie eben auch der Aufbau von potential gefährlichen „Beziehungen“.

Zahlen & Fakten

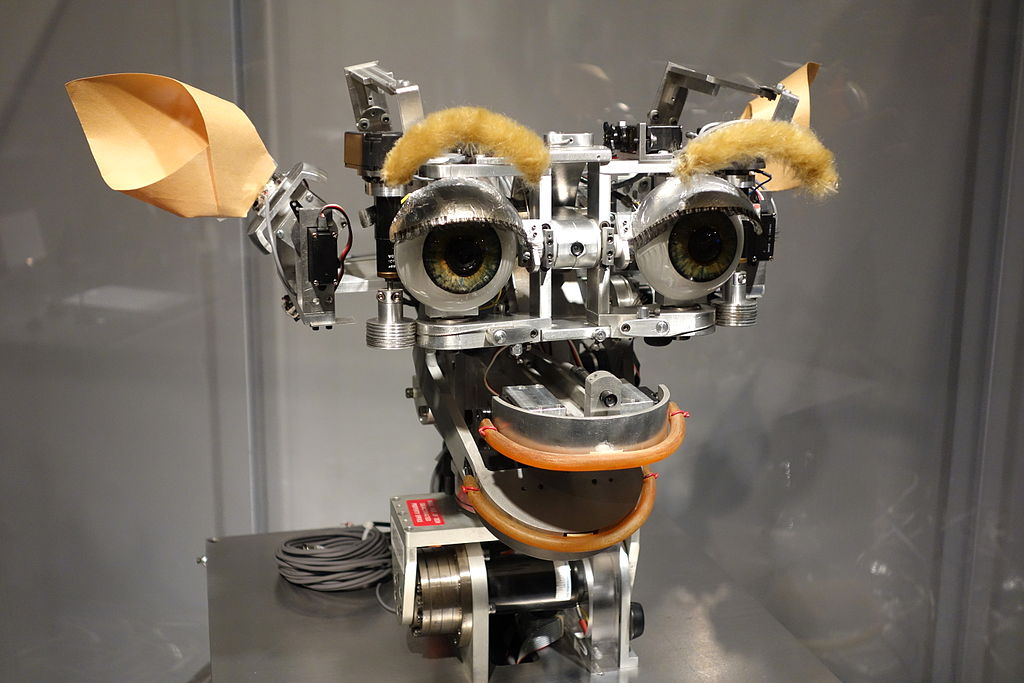

Kismet und Leonardo, Roboter mit Gefühl

Um die Jahrtausendwende wurde in Boston am Forschungsinstitut MIT an einer anderen Form von KI gearbeitet: Roboter, die wie Kinder lernen und Emotionen zeigen. An einem davon, Kismet, hat auch Anne Foerst als theologische Beraterin mitgearbeitet. Kismet – große Glubschaugen, roter Mund und rosa Schweineohren auf einem Gerüst aus Metall –, konnte nicht nur Emotionen mit den dazu passenden Gesichtsausdrücken darstellen. Er hat auch neue Emotionen und dazu passende Gesichtsausdrücke gelernt oder vielleicht sogar: empfunden.

Das Nachfolgemodell Leonardo – kleinere Augen, aber riesige, flauschige Ohren – meisterte zur Überraschung aller sogar den „Sally-und-Anne-Test“, ein Experiment aus der Entwicklungspsychologie. Ein Kind beobachtet zwei Puppen, Sally und Anne. Die Puppe Sally gibt eine Murmel in eine verschließbare Kiste und verlässt den Raum. Während ihrer Abwesenheit legt Anne die Murmel in eine andere Kiste. Nachdem Sally zurückgekehrt ist, wird das Kind gefragt: „Wo wird Sally das Spielzeug suchen?“

In Leonardos Fall fragt ein in den Raum zurückkommender Forscher, der Sallys Rolle innehat, zuerst: „Wo werde ich das Spielzeug suchen?“, und zur Kontrolle auch: „Wo ist das Spielzeug?“ Leonardo beantwortet beides richtig; sich normal entwickelnde Kinder bestehen diese Aufgabe meist erst mit vier Jahren. Sie erfordert die Fähigkeit, sich in ein Gegenüber hineinzuversetzen und zu verstehen, dass dieses Gegenüber ein anderes Wissen von der Welt hat.

Zum anderen ist das Angstpotential bei wirklich verkörperten Robotern viel höher. Geschichten wie der Zauberlehrling und Frankenstein sind tief in unserer kollektiven Psyche verankert. Wir fürchten die Maschine, die uns ähnlich oder vielleicht sogar ebenbürtig ist und sich gegen uns wendet und vielleicht sogar vernichtet.

Intelligente Maschinen: Partner oder Sklaven?

Ich dagegen finde einen solchen Ansatz spannend. Wäre es nicht spannend, statt der derzeitigen AI, die Intelligenz lediglich simuliert, Maschinen zu entwickeln, die wirklich intelligent sind? Es gibt natürlich in der Tierwelt viele Beispiele für Intelligenz, aber leider können wir mit anderen Tieren nur begrenzt kommunizieren. Eine Maschine dagegen hat unsere Kommunikationsfähigkeit und wir könnten mit ihr studieren, wie eine andere Intelligenz die Welt erlebt. Vielleicht könnten solche Maschinen uns sogar toleranter machen gegenüber Menschen mit völlig anderen Weltanschauungen!

Natürlich werden solche Maschinen auch ethische Fragen aufwerfen. Sollten wir solche Maschinen als Personen behandeln, die Rechte besitzen? Sollten wir sie in unsere Gesellschaft als ebenbürtige Partner einbinden, oder werden sie als reine Nutzobjekte behandelt? Und ist dies dann als eine Art von Sklaverei einzustufen?

Momentan sind wir von solchen Maschinen noch Jahre entfernt. Und derzeit steckt die AI-Gemeinschaft noch in der Einbahnstrasse der LLMs, obwohl mit dieser Architektur Allgemeine AI (General AI) wohl nicht möglich ist. Sollten aber die Forscherinnen und Forscher anfangen, verkörperte Machinen zu bauen, dann könnte wahre künstliche Intelligenz möglich werden und unsere Gesellschaft grundlegend verändern. Ich freue mich darauf.

Conclusio

Empathielos. ChatBots simulieren Intelligenz, besitzen aber keine Empathie. Ihre Antworten sind statistische Outputs, keine menschlichen Reaktionen.

Projektionsfläche. Wir projizieren Menschlichkeit in Maschinen, weil das unserer Entwicklung entspricht. Ohne Körperlichkeit bleibt AI jedoch begrenzt.

Verkörpert. Kritischer Umgang mit Sprachmodellen ist nötig. Investitionen in verkörperte Robotik könnten echte soziale Intelligenz hervorbringen.